고정 헤더 영역

상세 컨텐츠

본문 제목

[Coursera1] Neural-Networks-Deep-Learning : Logistic Regression - Loss /Cost Function, BackPropagation(w,b), Vectorization

본문

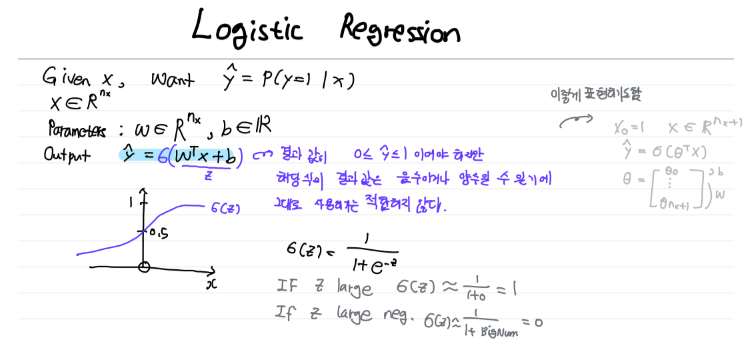

Loss Function

- single training dataset : 예측값이 실제 값과 얼마나 다른지

- 신경망 훈련에 도움

Cost Function

- 전체 training dataset

각 training dataset에 대한 Loss값의

1) 평균 (강의에서는 평균값 사용)

2) 중앙값

등을 이용해서 전체 training dataset에 대한 Cost Function을 정의한다.

초기값에서 부터,

Gradient Descent을 통해서,

Cost Function이 최소화되는 w와 b를 찾는 것(=Global Optimization에 가까운 w,b)이 목표이다.

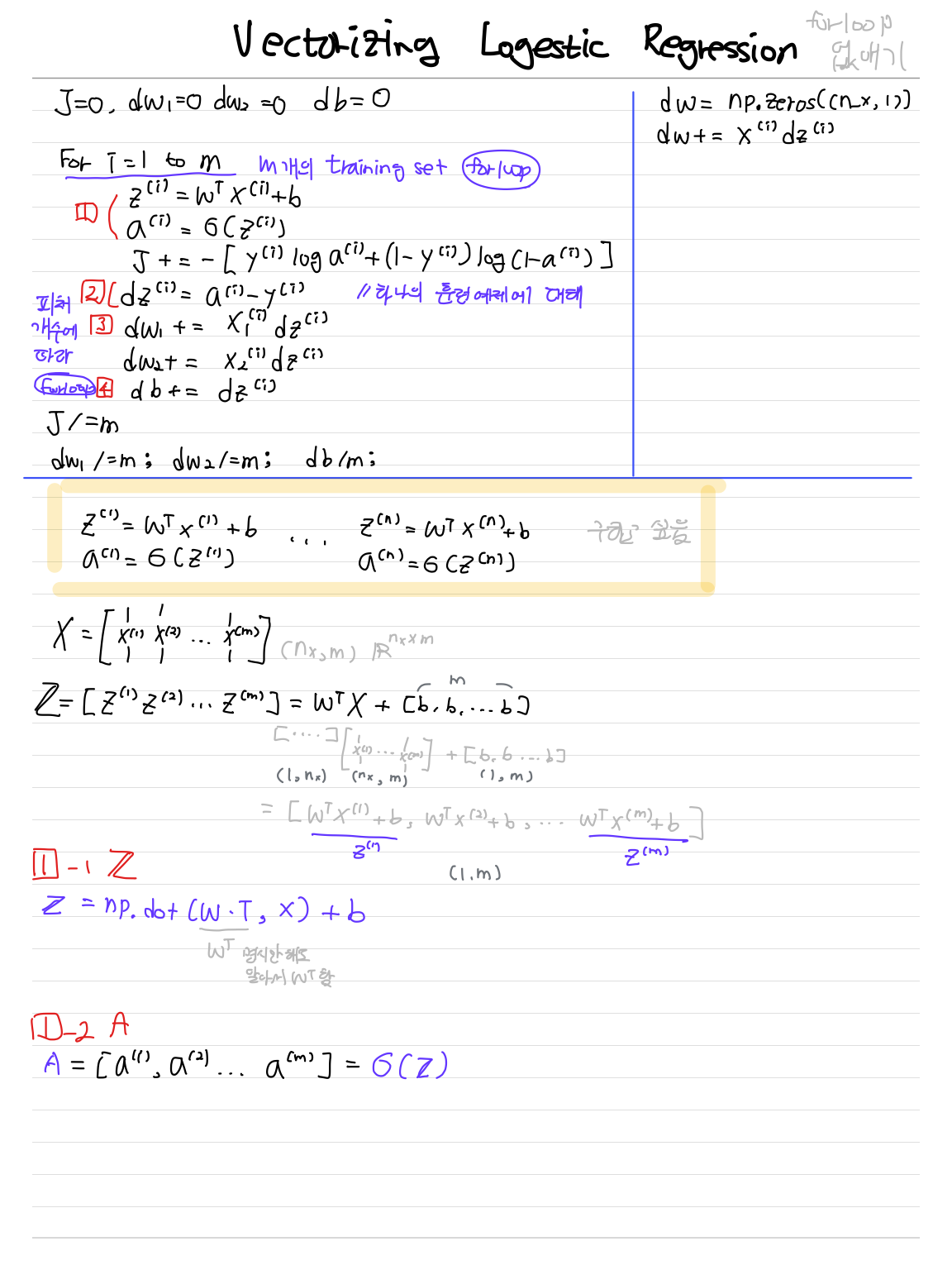

Back Propagation Step 을 통해 전체 training dataset에 적합한 w,b를 찾아보자

= Backward Pass

= Gradient(기울기)나 Derivation(도함수)

먼저, Back Propagation하여 Loss Function을 최소화하는

값을 구해보자 (단일 TrainingSet에 대하여 w,b 구하기)

예제에서 Cost Function는 각 training dataset의 Loss값의 평균이다.

Back Propagation하여 Cost Function을 최소화하는 값을 구해보자 (모든 TrainingSet에 대하여 w,b 구하기)

성능 향상을 위해 Vectorization을 이용해서 for loop를 최대한 없애자

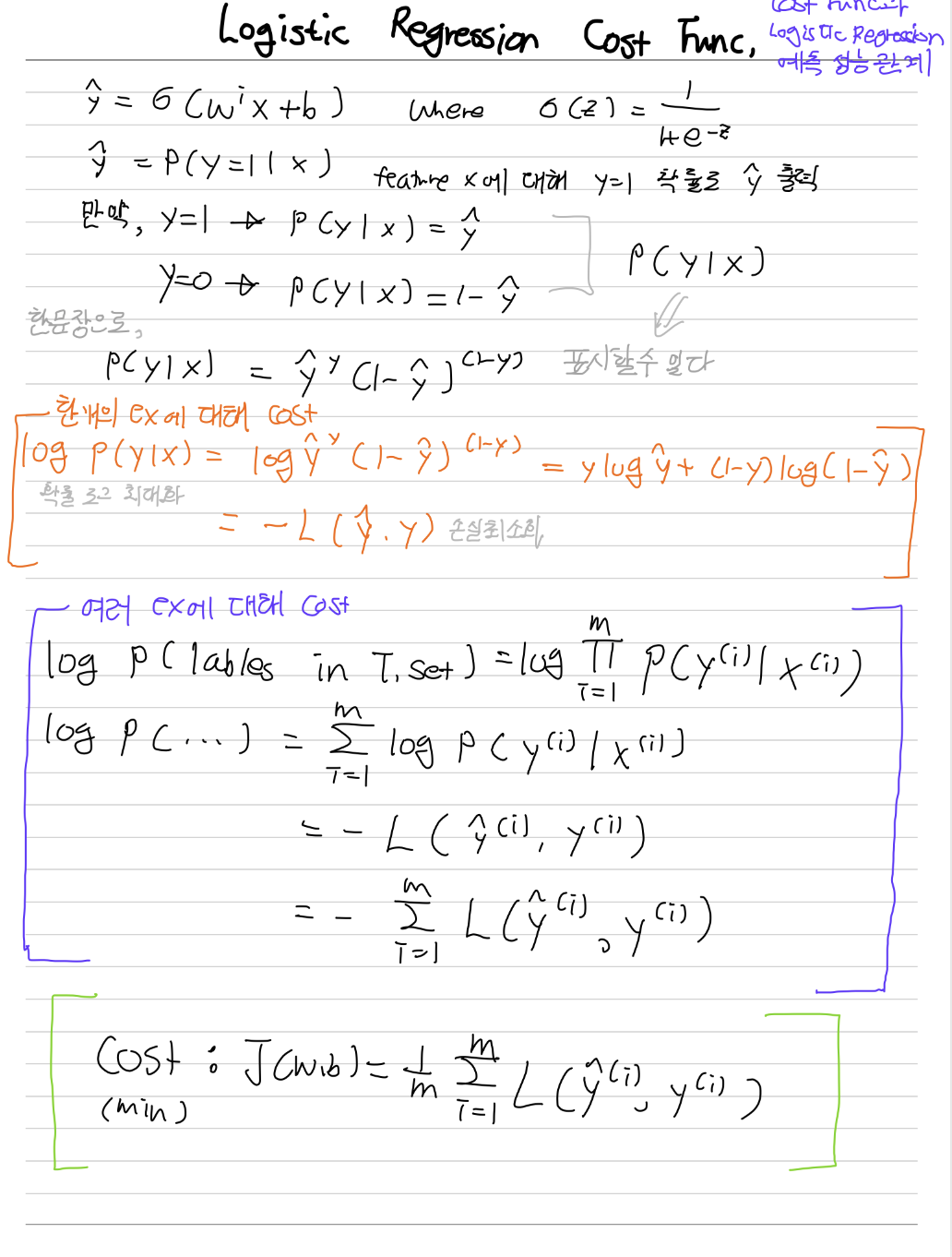

Logistic Regression의 Cost 를 줄이면, 모델의 최대 likelihood에 도달하는 이유

궁금했던 점을 동기에게 질문하다가 내가 답을 찾아버렸다. : )

강의의 Logistic Regression에서 Cost Function(J)를

각 training set에 대해서 Loss Function의 결과값의 평균으로 정의하고 있다.

만약 각 training set의 Loss Function 결과 값의 분포를 보니 특이값을 많이 포함하고 있다면,

평균으로 w와 b구하는 것이 이상적이지 않지 않는가?

>>> 평균이 아닌 다른 방법(MAD)을 사용해서 Cost Function 구한다...

https://leechanhyuk.github.io/machine_learning/Cost_function/

[Concept summary] Cost(Loss) function의 종류 및 특징

Cost(Loss) function

leechanhyuk.github.io

728x90